Manipulation des réseaux sociaux : comment fonctionne une ferme à troll

La ferme à trolls est une technique de manipulation très efficace, de plus en plus répandue sur les réseaux sociaux. Elle consiste à utiliser des faux-comptes dans le but de diffuser massivement un message destiné à influencer l’opinion publique.

La plupart du temps, ces campagnes de désinformation sont financées par des groupes politiques, des activistes ou des entreprises peu scrupuleuses. Même si elles sont difficiles à identifier, le meilleur moyen de s’en prémunir est de rester conscient de leur existence, d’en comprendre le mécanisme et d’acquérir quelques points de repères pour les détecter.

Un troll, un bot, un netbot : en quoi cela consiste-t-il ?

Le terme « troll » est principalement utilisé pour désigner une personne qui offense ouvertement et agressivement un utilisateur pour initier un conflit. Il cherche donc à jeter de l’huile sur le feu pour faire dérailler les conversations et provoquer des réponses émotionnelles qui bannissent toute réflexion constructive. Dans le cas des fermes organisées, les trolls s’immiscent dans les conversations et diffusent de faux messages avec de faux comptes.

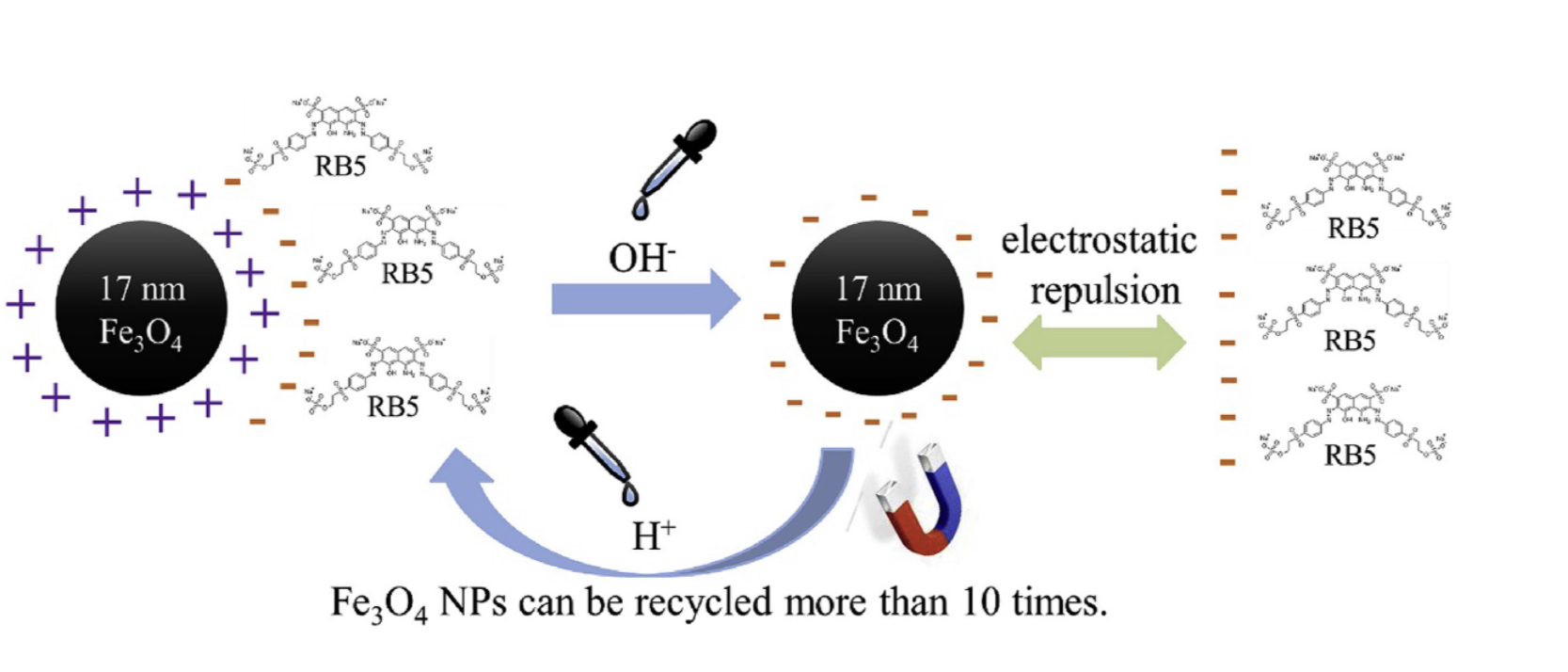

Un bot est également un faux-compte, mais il n’est pas géré par une vraie personne. C’est donc un robot qui est programmé le plus souvent pour partager, liker ou retweeter des milliers de fois un message identique. Un netbot rassemble en réseau une grande quantité de bots servant le même objectif.

Lorsque les fermes à trolls sont secondées par un réseau de bots, elles deviennent des armes redoutables, capables d’influencer des élections nationales ou de déstabiliser tout un pays. Un système d’autant plus efficace qu’il n’est pas toujours très onéreux.

Qui fait usage des fermes à trolls et pourquoi ?

On ne compte plus le nombre d’articles du New York Times ou du Guardian détaillant des campagnes de trolling à grande envergure. Ces dernières peuvent avoir des projets très variés tels qu’influencer les résultats des élections américaines, propager une image pro-Poutine en Russie ou en Ukraine, provoquer des manifestations, décrédibiliser la démocratie ou encore affaiblir l’économie européenne.

En 2019, L’INA, la revue française des médias, accusait 48 Etats de pratiquer le trolling politique. En 2020, le Service européen de l’action extérieure dénombrait 80 campagnes issues de médias russes pro-Kremlin ciblant directement l’Union européenne.

Ces campagnes colportent des fake news pour inciter les gens à se rallier à ce qu’on veut leur faire croire. Elles créent aussi l’illusion qu’une importante communauté de personnes partagent un avis, qu’il y a un réel mouvement populaire sur une thématique, alors que ce n’est pas le cas.

Mais l’action politique n’est pas l’unique objectif de ces campagnes. Il peut également s’agir de truquer un sondage en utilisant un nombre calculé de faux-comptes pour manipuler les résultats. Certaines entreprises n’hésitent pas à s’approprier la technique en vue de décrédibiliser un concurrent, de diffuser une gigantesque campagne publicitaire ou d’amplifier les messages positifs sur leurs produits. Il est techniquement possible de louer un netbot ou une ferme à trolls pour une action courte et précise.

Comment se déroule une campagne de fausse information ?

En mai 2020, un Community manager d’une agence internationale s’est confié anonymement dans El Pais. Il y explique en détail la stratégie d’amplification artificielle de messages sur Twitter.

Pour chaque projet, des conversations sont analysées et une cartographie des acteurs du débat est dressée, avec une liste des comptes favorables et défavorables.

Les trolls savent ainsi avec qui ils doivent interagir. D’après son témoignage, il existe deux catégories de trolls : les « alpha » et les « bêta ». Les « alpha » s’arrangent pour devenir populaires et interagissent avec les experts reconnus et les internautes. Ils prennent parfois le relais des bots lorsque ceux-ci sont interpellés personnellement. Les « bêta » jouent leur rôle de troll en insultant certains profils réputés, ce qui a pour effet d’enflammer les commentaires et d’amener les experts à s’autocensurer.

En parallèle, une armée de bots est programmée pour liker ou retweeter des posts et pour diffuser des messages à des heures programmées. Cela permet de faire gagner rapidement une thématique ou une personne en popularité.

Une campagne ainsi organisée exige entre 1500 et 2000 bots et trolls et peut coûter jusqu’à un million d’euros.

Il existe une série de tactiques à suivre pour empêcher Twitter de repérer les trolls :

- Ils ne se suivent pas entre eux et ont peu d’interactions les uns avec les autres pour éviter qu’on ne puisse cartographier le réseau

- Ils évitent les modèles répétitifs en utilisant des schémas d’écriture différents

- Ils utilisent des API différents et modifient leurs adresses IP

- Chaque compte est personnalisé avec une photo, un nom et une biographie.

Quelques astuces pour identifier les faux comptes Twitter

Le Digital Forensic Research Lab (DFRLab) a identifié 12 critères qui peuvent aider à repérer un bot sur Twitter :

- L’activité : selon Oxford Internet Institute et @DFRLab, un compte devient suspect s’il diffuse plus de 50 ou 70 tweets par jour. Au-delà de 144 tweets, il est considéré comme hautement suspect. Surtout si ces périodes d’hyperactivité alternent avec des mois d’inactivité.

- L’anonymat : le plus souvent, les faux comptes ont des avatars anonymes. Leur biographie ne dévoile aucune information personnelle et la localisation est indéfinie ou imprécise.

- L’amplification : en recherchant sous l’onglet « Tweets et réponses », on se rend compte qu’un bot a un large pourcentage de retweets ou de citations intégrales de l’actualité. Il peut partager les nouvelles d’un site donné, mais sans commentaire.

- Peu de messages/beaucoup de réactions : si le compte n’a diffusé que quelques messages likés des milliers de fois, il y a de grandes chances pour que cela cache un robot.

- Contenu commun : si de nombreux comptes partagent un contenu identique, il est possible qu’il s’agisse d’un réseau de bots.

- Lorsque les retweets d’un message sont effectués par des comptes majoritairement sans photo de profil, il y a des raisons de se méfier.

- Les faux profils utilisent parfois des photos volées. Une recherche inversée sur l’image de profil avec Google image permettra de les identifier.

- Certains noms doivent éveiller l’attention, comme des descripteurs alphanumériques ou des noms qui ne correspondent pas au profil (un nom masculin pour une photo de femme, par exemple).

- Lorsqu’une personne écrit dans de nombreuses langues différentes, il est possible que ce soit un faux profil. Surtout si l’objet principal de ses publications est d’ordre publicitaire.

- Les profils qui ne publient que des annonces publicitaires sont suspects. Il peut en effet s’agir de botnets commerciaux loués à une entreprise désireuse de booster sa publicité.

- Lorsque les publications d’un profil passent toutes par une plateforme de diffusion automatique, comme TweetDeck ou IFTTT, il est intéressant de vérifier s’il s’agit d’une vraie personne.

- Lorsque la liste des personnes qui retweetent est presque identique à la liste des personnes qui likent le tweet, il vaut mieux vérifier s’il s’agit bien d’une vraie personne.